您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關怎么利用python實現AR,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

大致步驟如下:

識別參考平面

在這一步中,我們所需要做的事就是提取參考圖像和目標圖像的sift特征,然后使用RANSAC算法穩健地估計單應性矩陣。

代碼如下:

#計算特征

sift.process_image('D:輸入圖片/book_frontal.JPG', 'im0.sift')

l0, d0 = sift.read_features_from_file('im0.sift')

sift.process_image('D:輸入圖片/book_per.JPG', 'im1.sift')

l1, d1 = sift.read_features_from_file('im1.sift')

#匹配特征,并計算單應性矩陣

matches = sift.match_twosided(d0, d1)

ndx = matches.nonzero()[0]

fp = homography.make_homog(l0[ndx, :2].T)

ndx2 = [int(matches[i]) for i in ndx]

tp = homography.make_homog(l1[ndx2, :2].T)

model = homography.RansacModel()

H, inliers = homography.H_from_ransac(fp, tp, model)由上面代碼可得到單應性矩陣,它能夠將一幅圖像中標記物的點映射到另一幅圖像中的對應點。還需要建立X-Y(Z=0)三維坐標系,標記物在Z=0平面上,原點在標記物的某個位置上。

從單應性推導出從參考面坐標系到目標圖像坐標系的轉換

在進行坐標轉換之前,為了檢驗單應性矩陣結果的正確性,需要將一些三維物體放置在目標圖像上,本實驗使用了一個立方體。產生立方體的代碼如下:

def cube_points(c, wid): p = [] p.append([c[0]-wid, c[1]-wid, c[2]-wid]) p.append([c[0]-wid, c[1]+wid, c[2]-wid]) p.append([c[0]+wid, c[1]+wid, c[2]-wid]) p.append([c[0]+wid, c[1]-wid, c[2]-wid]) p.append([c[0]-wid, c[1]-wid, c[2]-wid]) p.append([c[0]-wid, c[1]-wid, c[2]+wid]) p.append([c[0]-wid, c[1]+wid, c[2]+wid]) p.append([c[0]+wid, c[1]+wid, c[2]+wid]) p.append([c[0]+wid, c[1]-wid, c[2]+wid]) p.append([c[0]-wid, c[1]-wid, c[2]+wid]) p.append([c[0]-wid, c[1]-wid, c[2]+wid]) p.append([c[0]-wid, c[1]+wid, c[2]+wid]) p.append([c[0]-wid, c[1]+wid, c[2]-wid]) p.append([c[0]+wid, c[1]+wid, c[2]-wid]) p.append([c[0]+wid, c[1]+wid, c[2]+wid]) p.append([c[0]+wid, c[1]-wid, c[2]+wid]) p.append([c[0]+wid, c[1]-wid, c[2]-wid] return array(p).T

先計算出照相機的標定矩陣,就可以得出兩個視圖間的相對變換

代碼如下:

#計算照相機標定矩陣,使用圖像的分辨率為747*1000 K = my_calibration((747, 1000)) #位于邊長為0.2,Z=0平面上的三維點 box = cube_points([0, 0, 0.1], 0.1) #投影第一幅圖像上底部的正方形 cam1 = camera.Camera(hstack((K, dot(K, array([[0], [0], [-1]]))))) #底部正方形上的點 box_cam1 = cam1.project(homography.make_homog(box[:, :5])) #使用H將點變換到第二幅圖像上 box_trans = homography.normalize(dot(H,box_cam1)) #從cam1和H中計算第二個照相機矩陣 cam2 = camera.Camera(dot(H, cam1.P)) A = dot(linalg.inv(K), cam2.P[:, :3]) A = array([A[:, 0], A[:, 1], cross(A[:, 0], A[:, 1])]).T cam2.P[:, :3] = dot(K, A) #使用第二個照相機矩陣投影 box_cam2 = cam2.project(homography.make_homog(box))

在圖像(像素空間)中投影我們的3D模型并繪制它。

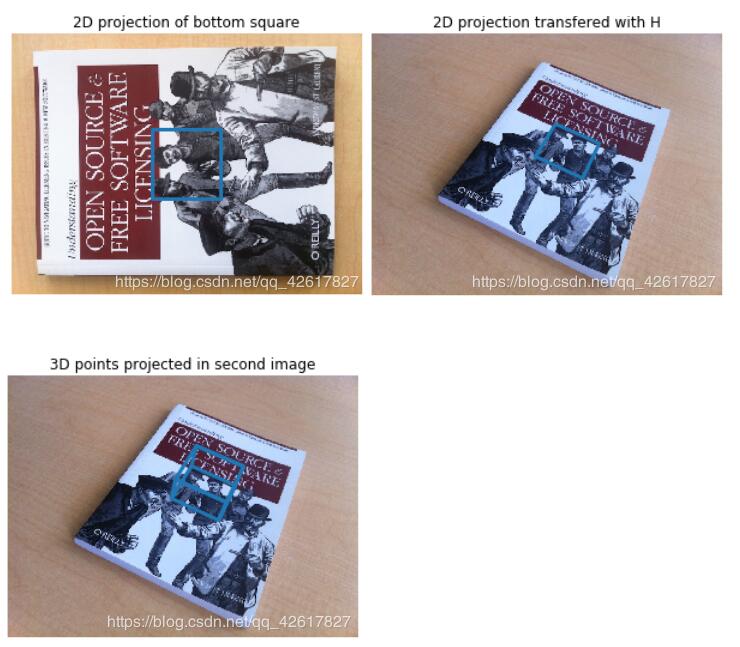

#底部正方形的二維投影

figure()

imshow(im0)

plot(box_cam1[0, :], box_cam1[1, :], linewidth=3)

title('2D projection of bottom square')

axis('off')

#使用H對二維投影進行變換

figure()

imshow(im1)

plot(box_trans[0, :], box_trans[1, :], linewidth=3)

title('2D projection transfered with H')

axis('off')

#三維立方體

figure()

imshow(im1)

plot(box_cam2[0, :], box_cam2[1, :], linewidth=3)

title('3D points projected in second image')

axis('off')實驗結果如下

什么是AR

AR全稱Augmented Reality,意為增強現實技術。

它是一種將真實世界信息和虛擬世界信息“無縫”集成的新技術,是把原本在現實世界的一定時間空間范圍內很難體驗到的實體信息(視覺信息,聲音,味道,觸覺等),通過電腦等科學技術,模擬仿真后再疊加,將虛擬的信息應用到真實世界,被人類感官所感知,從而達到超越現實的感官體驗。真實的環境和虛擬的物體實時地疊加到了同一個畫面或空間同時存在。

增強現實技術,不僅展現了真實世界的信息,而且將虛擬的信息同時顯示出來,兩種信息相互補充、疊加。在視覺化的增強現實中,用戶利用頭盔顯示器,把真實世界與電腦圖形多重合成在一起,便可以看到真實的世界圍繞著它。

增強現實技術包含了多媒體、三維建模、實時視頻顯示及控制、多傳感器融合、實時跟蹤及注冊、場景融合等新技術與新手段。增強現實提供了在一般情況下,不同于人類可以感知的信息。

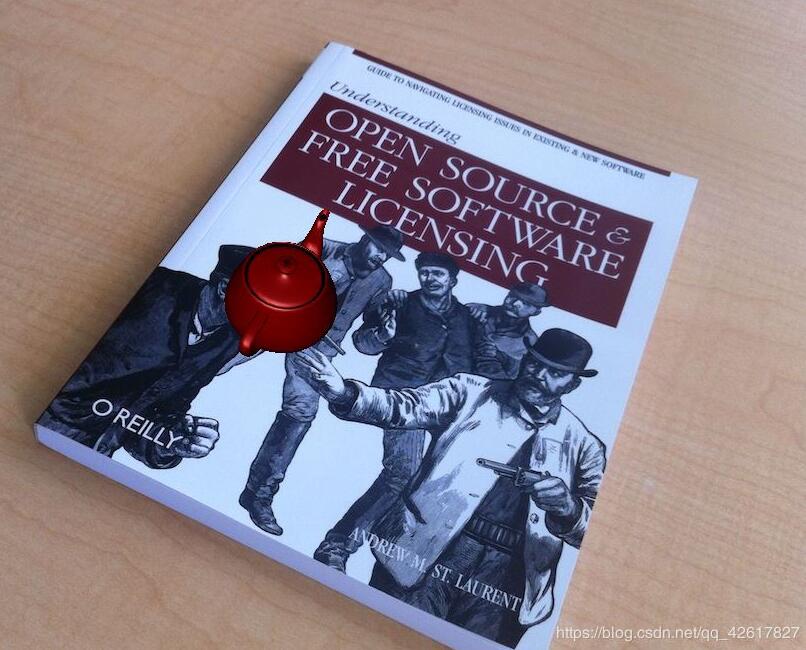

如何利用python實現AR

步驟和實現姿態估計無太大差別。由上述內容計算出照相機的位置和姿態,使用這些信息來放置計算機圖像學模型。這里我們放置了一個紅色的小茶壺。

在運行代碼之前,我們需要先安裝PyGame和PyOpenGL,下載鏈接(https://www.lfd.uci.edu/~gohlke/pythonlibs/)。

核心代碼如下:

def set_projection_from_camera(K):

#從照相機標定矩陣中獲得視圖

glMatrixMode(GL_PROJECTION)

glLoadIdentity()

fx = K[0,0]

fy = K[1,1]

fovy = 2*math.atan(0.5*height/fy)*180/math.pi

aspect = (width*fy)/(height*fx)

near = 0.1

far = 100.0

gluPerspective(fovy,aspect,near,far)

glViewport(0,0,width,height)

def set_modelview_from_camera(Rt):

#從照相機姿態中獲取模擬視圖矩陣

glMatrixMode(GL_MODELVIEW)

glLoadIdentity()

Rx = np.array([[1,0,0],[0,0,-1],[0,1,0]])

R = Rt[:,:3]

U,S,V = np.linalg.svd(R)

R = np.dot(U,V)

R[0,:] = -R[0,:]

t = Rt[:,3]

M = np.eye(4)

M[:3,:3] = np.dot(R,Rx)

M[:3,3] = t

M = M.T

m = M.flatten()

glLoadMatrixf(m)

def draw_background(imname):

#使用四邊形繪制背景圖像

bg_image = pygame.image.load(imname).convert()

bg_data = pygame.image.tostring(bg_image,"RGBX",1)

glMatrixMode(GL_MODELVIEW)

glLoadIdentity()

glClear(GL_COLOR_BUFFER_BIT | GL_DEPTH_BUFFER_BIT)

glEnable(GL_TEXTURE_2D)

glBindTexture(GL_TEXTURE_2D,glGenTextures(1))

glTexImage2D(GL_TEXTURE_2D,0,GL_RGBA,width,height,0,GL_RGBA,GL_UNSIGNED_BYTE,bg_data)

glTexParameterf(GL_TEXTURE_2D,GL_TEXTURE_MAG_FILTER,GL_NEAREST)

glTexParameterf(GL_TEXTURE_2D,GL_TEXTURE_MIN_FILTER,GL_NEAREST)

glBegin(GL_QUADS)

glTexCoord2f(0.0,0.0); glVertex3f(-1.0,-1.0,-1.0)

glTexCoord2f(1.0,0.0); glVertex3f( 1.0,-1.0,-1.0)

glTexCoord2f(1.0,1.0); glVertex3f( 1.0, 1.0,-1.0)

glTexCoord2f(0.0,1.0); glVertex3f(-1.0, 1.0,-1.0)

glEnd()

glDeleteTextures(1)

def draw_teapot(size):

#在原點處繪制紅色茶壺

glEnable(GL_LIGHTING)

glEnable(GL_LIGHT0)

glEnable(GL_DEPTH_TEST)

glClear(GL_DEPTH_BUFFER_BIT)

glMaterialfv(GL_FRONT,GL_AMBIENT,[0,0,0,0])

glMaterialfv(GL_FRONT,GL_DIFFUSE,[0.5,0.0,0.0,0.0])

glMaterialfv(GL_FRONT,GL_SPECULAR,[0.7,0.6,0.6,0.0])

glMaterialf(GL_FRONT,GL_SHININESS,0.25*128.0)

glutSolidTeapot(size)

width,height = 1000,747

def setup():

pygame.init()

pygame.display.set_mode((width,height),OPENGL | DOUBLEBUF)

pygame.display.set_caption("OpenGL AR demo")實驗結果如圖:

運行代碼遇到的錯誤及解決方案

錯誤如下:An error ocurred while starting the kernelfreeglut ERROR: Function called without first calling ‘glutInit'.

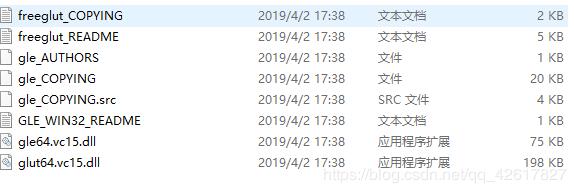

原因:經大神指點得知這個錯誤是freeglut和glut共存的緣故,它們倆定義了相同的方法,這個是動態鏈接庫的重疊問題,我的在ana\Lib\site-packages\OpenGL\DLLS文件夾里面。

你需要刪除freeglut.vc15.dll這個文件。我這是已經刪除完的樣子。

關于“怎么利用python實現AR”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。