您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

1、hbase概述

1.1 hbase是什么

hbase是基于hdfs進行數據的分布式存儲,具有高可靠、高性能、列存儲、可伸縮、實時讀寫的nosql數據庫。

hbase可以存儲海量的數據,并且后期查詢性能很高,可以實現上億條數據的查詢秒級返回結果。

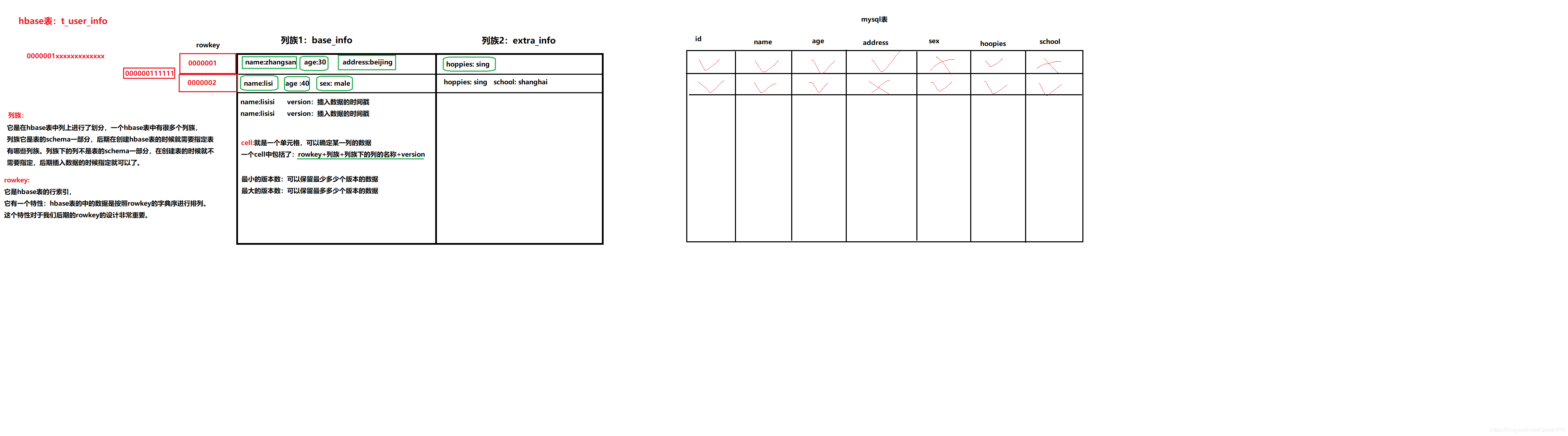

1.2 hbase表的特性

1、大

2、無模式

3、面向列

4、稀疏

5、數據的多版本

6、數據類型單一

1.3 hbase表的邏輯視圖

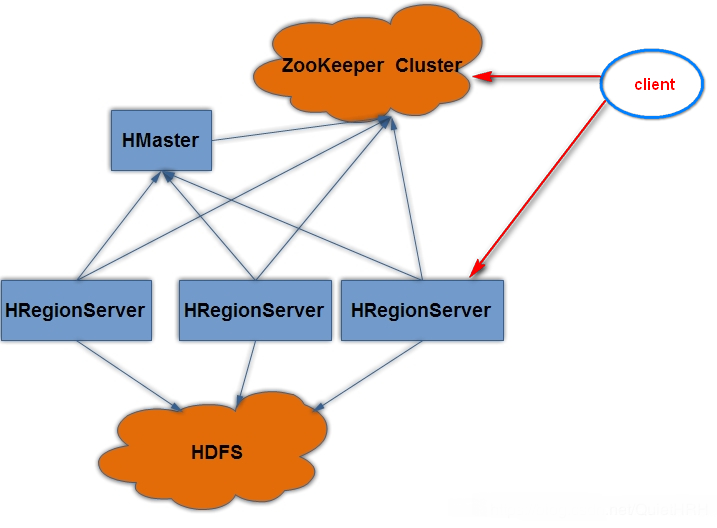

2、hbase的集群結構

1、client

2、zookeeper

客戶端操作hbase表數據需要一個zk集群

作用

1、zk保存了hbase集群的元數據信息

存儲 Hbase 的 schema,包括有哪些 table,每個 table 有哪些 column family

2、zk保存所有hbase表的尋址入口

后期通過客戶端接口去操作hbase數據的時候,需要連接上zk集群

存貯所有 Region 的尋址入口----root 表在哪臺服務器上3、通過引入了zk之后,實現了整個hbase集群高可用

4、zk保存了HMaster和HRegionServer它們的注冊和心跳信息

后期哪一個HRegionServer掛掉之后,zk也會感知到,然后把這個信息通知給老大HMaster

3、HMaster

它是整個hbase集群老大

作用

1、它接受客戶端創建表、刪除表的請求。處理 schema 更新請求

2、它會給HRegionServer分配對應的region,進行數據的管理

3、它會把掛掉的HRegionServer所管理的region重新分配給其他的活著的HRegionServer

4、它會實現HRegionServer負載均衡,避免某一個HRegionServer管理的region過多。

4、HRegionServer

它是整合hbase集群的小弟

作用

1、負責管理HMaster老大給它分配的region

2、它會接受到客戶端的讀寫請求

3、它會把在運行過程中,變得過大的region數據進行切分

5、Region

它是整個hbase表中分布式存儲的最小單元

它的數據是基于hdfs進行存儲

3、hbase集群安裝部署

前提條件

1、下載對應的安裝包

2、規劃安裝目錄

3、上傳安裝包到服務器中

4、解壓安裝包到指定的規劃目錄

5、重命名解壓目錄

6、修改配置文件

需要把hadoop安裝目錄下/etc/hadoop文件夾中

需要把以上2個hadoop的配置文件拷貝到hbase安裝目錄下的conf文件夾中

1、vim hbase-env.sh

#配置java環境變量 export JAVA_HOME=/export/servers/jdk #指定hbase集群由外部的zk集群去管理,不在使用自帶的zk集群 export HBASE_MANAGES_ZK=false

2、vim hbase-site.xml

<!-- 指定hbase在HDFS上存儲的路徑 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://node1:9000/hbase</value>

</property>

<!-- 指定hbase是分布式的 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 指定zk的地址,多個用“,”分割 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>node1:2181,node2:2181,node3:2181</value>

</property>

3、vim regionservers

#指定哪些節點是HRegionServer node2 node3

4、vim backup-masters

#指定哪些節點是備用的Hmaster node2

7、配置hbase環境變量

vim /etc/profile

export HBASE_HOME=/export/servers/hbase export PATH=$PATH:$HBASE_HOME/bin

8、分發hbase目錄和環境變量

scp -r hbase node2:/export/servers scp -r hbase node3:/export/servers scp /etc/profile node2:/etc scp /etc/profile node3:/etc

9、讓所有hbase節點的環境變量生效

在所有節點上執行

4、hbase集群的啟動和停止

1、啟動hbase集群

先啟動zk和hadoop集群

然后通過hbase/bin

start-hbase.sh

2、停止hbase集群

通過hbase/bin

stop-hbase.sh

hbase集群web管理界面

1、啟動好hbase集群之后

訪問地址

HMaster主機名:16010

5、hbase shell 命令行操作

hbase/bin/hbase shell 進入到hbase shell客戶端命令操作

1、創建一個表

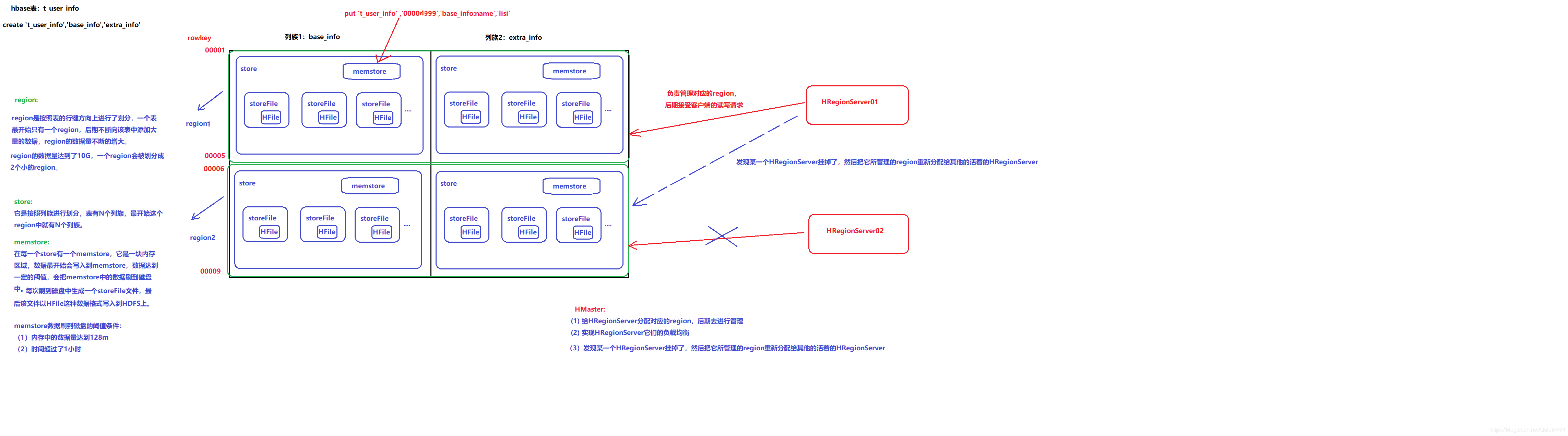

create 't_user_info','base_info','extra_info'

create 't1', {NAME => 'f1'}, {NAME => 'f2'}, {NAME => 'f3'}

2、查看有哪些表

list 類似于mysql表中sql:show tables

3、查看表的描述信息

describe 't_user_info'

4、修改表的屬性

#修改列族的最大版本數 alter 't_user_info', NAME => 'base_info', VERSIONS => 3

5、添加數據到表中

put 't_user_info','00001','base_info:name','zhangsan' put 't_user_info','00001','base_info:age','30' put 't_user_info','00001','base_info:address','beijing' put 't_user_info','00001','extra_info:school','shanghai' put 't_user_info','00002','base_info:name','lisi'

6、查詢表的數據

//按照條件查詢

get 't_user_info','00001'

get 't_user_info','00001', {COLUMN => 'base_info'}

get 't_user_info','00001', {COLUMN => 'base_info:name'}

get 't_user_info','00001',{TIMERANGE => [1544243300660,1544243362660]}

get 't_user_info','00001',{COLUMN => 'base_info:age',VERSIONS =>3}

//全表查詢

scan 't_user_info'

7、刪除數據

delete 't_user_info','00001','base_info:name' deleteall 't_user_info','00001'

8、刪除表

disable 't_user_info' drop 't_user_info'

6、hbase的內部原理

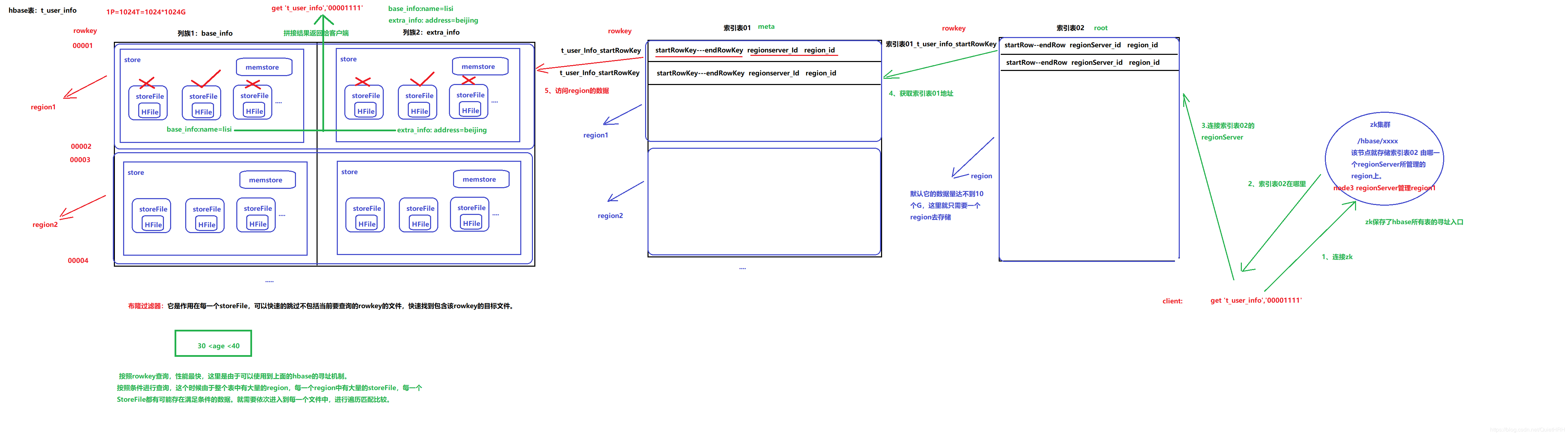

7、hbase的尋址機制

尋找 RegionServer

-ROOT-表

.META.表

聯系 regionserver 查詢目標數據

regionserver 定位到目標數據所在的 region,發出查詢請求

region 先在 memstore 中查找,命中則返回

如果在 memstore 中找不到,則在 storefile 中掃描(可能會掃描到很多的 storefile----bloomfilter 布隆過濾器)布隆過濾器可以快速的返回查詢的rowkey是否在這個storeFile中, 但也有誤差, 如果返回沒有,則一定沒有,如果返回有, 則可能沒有

8、Hbase高級應用

建表

BLOOMFILTER 默認是 Row 布隆過濾器

VSRSIONS 默認是 1 數據版本

COMPRESSION 默認值是 NONE 壓縮

disable_all ‘toplist.*' disable_all 支持正則表達式,并列出當前匹配的表 drop_all也相同

hbase 表預分區----手動分區

一種可以加快批量寫入速度的方法是通過預先創建一些空的 regions,這樣當數據寫入 HBase時,會按照 region 分區情況,在集群內做數據的負載均衡。減少數據達到 storefile 大小的時候自動分區的

時間消耗,并且還有以一個優勢,就是合理設計 rowkey 能讓各個 region 的并發請求平均分配(趨于均勻) 使 IO 效率達到最高,

行鍵設計

列族盡量少, 一般2-3個

rowkey

盡量減少行鍵和列族的大小在 HBase 中,value 永遠和它的 key 一起傳輸的

HFile中每個cell都會存儲rowkey, rowkey過大會影響存儲效率

MemStore 將緩存部分數據到內存,如果 rowkey 字段過長,內存的有效利用率就會降低,系統不能緩存更多的數據,這樣會降低檢索效率。

建議將 rowkey 的高位作為散列字段,由程序隨機生成,低位放時間字段,這樣將提高數據均衡分布在每個 RegionServer,以實現負載均衡的幾率。( 盾 )

rowkey矛盾

熱點解決

可以用 Long.Max_Value - timestamp 追加到 key 的末尾,例如 [key][reverse_timestamp] ,[key] 的最新值可以通過 scan [key]獲得[key]的第一條記錄,因為 HBase 中 rowkey 是有序的,第一條記錄是最后錄入的數據。

總結

以上就是這篇文章的全部內容了,希望本文的內容對大家的學習或者工作具有一定的參考學習價值,謝謝大家對億速云的支持。如果你想了解更多相關內容請查看下面相關鏈接

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。