您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家分享的是有關Apache Spark 2.0在作業完成時卻花費很長時間結束怎么辦的內容。小編覺得挺實用的,因此分享給大家做個參考,一起跟隨小編過來看看吧。

現象

大家在使用 Apache Spark 2.x 的時候可能會遇到這種現象:雖然我們的 Spark Jobs 已經全部完成了,但是我們的程序卻還在執行。比如我們使用 Spark SQL 去執行一些 SQL,這個 SQL 在最后生成了大量的文件。然后我們可以看到,這個 SQL 所有的 Spark Jobs 其實已經運行完成了,但是這個查詢語句還在運行。通過日志,我們可以看到 driver 節點正在一個一個地將 tasks 生成的文件移動到最終表的目錄下面,當我們作業生成的文件很多的情況下,就很容易產生這種現象。

為什么會造成這個現象

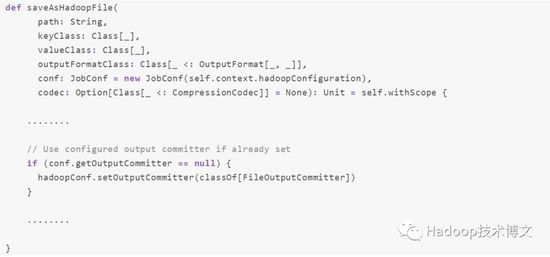

Spark 2.x 用到了 Hadoop 2.x,其將生成的文件保存到 HDFS 的時候,最后會調用了 saveAsHadoopFile,而這個函數在里面用到了 FileOutputCommitter,如下:

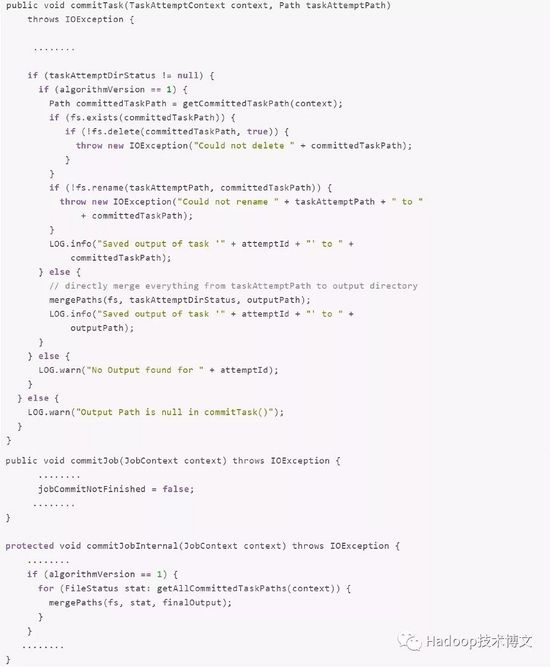

問題就出在了 Hadoop 2.x 的 FileOutputCommitter 實現FileOutputCommitter 里面有兩個值得注意的方法:commitTask 和 commitJob。在 Hadoop 2.x 的FileOutputCommitter 實現里面,mapreduce.fileoutputcommitter.algorithm.version 參數控制著 commitTask 和 commitJob 的工作方式。具體代碼如下(為了說明方便,我去掉了無關緊要的語句,完整代碼可以參見 FileOutputCommitter.java):

大家可以看到 commitTask 方法里面,有個條件判斷 algorithmVersion == 1,這個就是 mapreduce.fileoutputcommitter.algorithm.version 參數的值,默認為1;如果這個參數為1,那么在 Task 完成的時候,是將 Task 臨時生成的數據移到 task 的對應目錄下,然后再在 commitJob 的時候移到最終作業輸出目錄,而這個參數,在 Hadoop 2.x 的默認值就是 1!這也就是為什么我們看到 job 完成了,但是程序還在移動數據,從而導致整個作業尚未完成,而且最后是由 Spark 的 Driver 執行 commitJob 函數的,所以執行的慢也是有到底的。

而我們可以看到,如果我們將 mapreduce.fileoutputcommitter.algorithm.version 參數的值設置為 2,那么在 commitTask 執行的時候,就會調用 mergePaths 方法直接將 Task 生成的數據從 Task 臨時目錄移動到程序最后生成目錄。而在執行 commitJob 的時候,直接就不用移動數據了,自然會比默認的值要快很多。

注意,其實在 Hadoop 2.7.0 之前版本,我們可以將 mapreduce.fileoutputcommitter.algorithm.version 參數設置為非1的值就可以實現這個目的,因為程序里面并沒有限制這個值一定為2,。不過到了 Hadoop 2.7.0,mapreduce.fileoutputcommitter.algorithm.version 參數的值必須為1或2,具體參見 MAPREDUCE-4815。

怎么在 Spark 里面設置這個參數

問題已經找到了,我們可以在程序里面解決這個問題。有以下幾種方法:

直接在 conf/spark-defaults.conf 里面設置 spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version 2,這個是全局影響的。

直接在 Spark 程序里面設置,spark.conf.set("mapreduce.fileoutputcommitter.algorithm.version", "2"),這個是作業級別的。

如果你是使用 Dataset API 寫數據到 HDFS,那么你可以這么設置 dataset.write.option("mapreduce.fileoutputcommitter.algorithm.version", "2")。

不過如果你的 Hadoop 版本為 3.x,mapreduce.fileoutputcommitter.algorithm.version 參數的默認值已經設置為2了,具體參見 MAPREDUCE-6336 和 MAPREDUCE-6406。

因為這個參數對性能有一些影響,所以到了 Spark 2.2.0,這個參數已經記錄在 Spark 配置文檔里面了 configuration.html,具體參見 SPARK-20107。

感謝各位的閱讀!關于“Apache Spark 2.0在作業完成時卻花費很長時間結束怎么辦”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,讓大家可以學到更多知識,如果覺得文章不錯,可以把它分享出去讓更多的人看到吧!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。