您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關雙向RNN:bidirectional_dynamic_rnn()函數怎么用,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

雙向RNN:bidirectional_dynamic_rnn()函數的使用詳解

先說下為什么要使用到雙向RNN,在讀一篇文章的時候,上文提到的信息十分的重要,但這些信息是不足以捕捉文章信息的,下文隱含的信息同樣會對該時刻的語義產生影響。

舉一個不太恰當的例子,某次工作會議上,領導進行“簡潔地”總結,他會在第一句告訴你:“下面,為了節約時間,我簡單地說兩點…”,(…此處略去五百字…),“首先,….”,(…此處略去一萬字…),“礙于時間的關系,我要加快速度了,下面我簡要說下第二點…”(…此處再次略去五千字…)“好的,我想說的大概就是這些”(…此處又略去了二百字…),“謝謝大家!”如果將這篇發言交給一個單層的RNN網絡去學習,因為“首先”和“第二點”中間隔得實在太久,等到開始學習“第二點”時,網絡已經忘記了“簡單地說兩點”這個重要的信息,最終的結果就只剩下在風中凌亂了。。。于是我們決定加一個反向的網絡,從后開始往前聽,對于這層網絡,他首先聽到的就是“第二點”,然后是“首先”,最后,他對比了一下果然僅僅是“簡要地兩點”,在于前向的網絡進行結合,就深入學習了領導的指導精神。

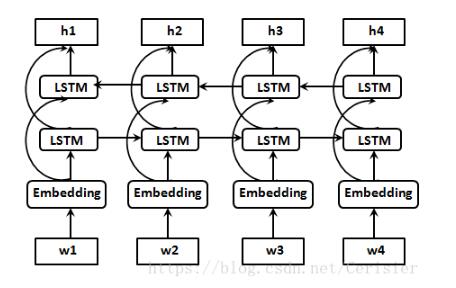

上圖是一個雙向LSTM的結構圖,對于最后輸出的每個隱藏狀態 都是前向網絡和后向網絡的元組,即

都是前向網絡和后向網絡的元組,即 其中每一個

其中每一個 或者

或者 又是一個由隱藏狀態和細胞狀態組成的元組(或者是concat)。同樣最終的output也是需要將前向和后向的輸出concat起來的,這樣就保證了在最終時刻,無論是輸出還是隱藏狀態都是有考慮了上文和下文信息的。

又是一個由隱藏狀態和細胞狀態組成的元組(或者是concat)。同樣最終的output也是需要將前向和后向的輸出concat起來的,這樣就保證了在最終時刻,無論是輸出還是隱藏狀態都是有考慮了上文和下文信息的。

下面就來看下tensorflow中已經集成的 tf.nn.bidirectional_dynamic_rnn() 函數。似乎雙向的暫時只有這一個動態的RNN方法,不過想想也能理解,這種結構暫時也只會在encoder端出現,無論你的輸入是pad到了定長或者是不定長的,動態RNN都是可以處理的。

具體的定義如下:

tf.nn.bidirectional_dynamic_rnn( cell_fw, cell_bw, inputs, sequence_length=None, initial_state_fw=None, initial_state_bw=None, dtype=None, parallel_iterations=None, swap_memory=False, time_major=False, scope=None )

仔細看這個方法似乎和dynamic_rnn()沒有太大區別,無非是多加了一個bw的部分,事實上也的確如此。先看下前向傳播的部分:

with vs.variable_scope(scope or "bidirectional_rnn"):

# Forward direction

with vs.variable_scope("fw") as fw_scope:

output_fw, output_state_fw = dynamic_rnn(

cell=cell_fw, inputs=inputs,

sequence_length=sequence_length,

initial_state=initial_state_fw,

dtype=dtype,

parallel_iterations=parallel_iterations,

swap_memory=swap_memory,

scope=fw_scope)完全就是一個dynamic_rnn(),至于你選擇LSTM或者GRU,只是cell的定義不同罷了。而雙向RNN的核心就在于反向的bw部分。剛才說過,反向部分就是從后往前讀,而這個翻轉的部分,就要用到一個reverse_sequence()的方法,來看一下這一部分:

with vs.variable_scope("bw") as bw_scope:

# ———————————— 此處是重點 ————————————

inputs_reverse = _reverse(

inputs, seq_lengths=sequence_length,

seq_dim=time_dim, batch_dim=batch_dim)

# ————————————————————————————————————

tmp, output_state_bw = dynamic_rnn(

cell=cell_bw,

inputs=inputs_reverse,

sequence_length=sequence_length,

initial_state=initial_state_bw,

dtype=dtype,

parallel_iterations=parallel_iterations,

swap_memory=swap_memory,

time_major=time_major,

scope=bw_scope)我們可以看到,這里的輸入不再是inputs,而是一個inputs_reverse,根據time_major的取值,time_dim和batch_dim組合的 {0,1} 取值正好相反,也就對應了時間維和批量維的詞序關系。

而最終的輸出:

outputs = (output_fw, output_bw) output_states = (output_state_fw, output_state_bw)

這里還有最后的一個小問題,output_states是一個元組的元組,我個人的處理方法是用c_fw,h_fw = output_state_fw和c_bw,h_bw = output_state_bw,最后再分別將c和h狀態concat起來,用tf.contrib.rnn.LSTMStateTuple()函數生成decoder端的初始狀態。

關于“雙向RNN:bidirectional_dynamic_rnn()函數怎么用”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。